Реально ли продвигать сайт в поисковиках самостоятельно? Если вы неспециалист в области SEO, то придется набить много шишек, действуя методом проб и ошибок. Чтобы облегчить ваш труд, рассмотрим самые типичные ошибки новичков в SEO-оптимизации, расскажем, как они появляются, влияют на ранжирование и главное – как их правильно исправлять.

Не те ключевые слова

Потенциальные клиенты не смогут найти ресурс или конкретную страницу, если семантическое ядро составлено неправильно. Нужно подбирать релевантные ключевики, которые соответствуют реальным запросам потенциальных клиентов. Работу над семантическим ядром лучше начинать с изучения целевой аудитории.

Нужно разобраться с тем, как формируется запрос у клиента и что побуждает его совершить целевое действие. Также будет нелишним проанализировать сайты успешных конкурентов. В результате будет сформировано хорошее семантическое ядро, а текстовая оптимизация страниц даст ожидаемый эффект.

На практике хорошую эффективность демонстрируют низкочастотные запросы, которые состоят из трех-четырех слов. Они более конкретные и менее конкурентные, чем средне или высокочастотные запросы, состоящие из одного или двух слов.

Например, в Yandex.Wordstat запрос «Стальные двери» имеет 90 тыс. показов ежемесячно. Если посмотреть словоформы, можно сразу выделить несколько релевантных и более длинных запросов, где основной ключ «стальные двери» сочетается со словами:

- «+купить»;

- «+цена»;

- «+Москва»;

- «+установка».

Дальнейшая работа с этими выражениями позволяет подобрать запросы для страниц сайта, а также для заголовка H1, description и title. Конкретные ключевики, которые соответствуют интересам ЦА, увеличат целевой трафик и выведут сайт на верхние строки поисковой выдачи.

Каннибализация ключей

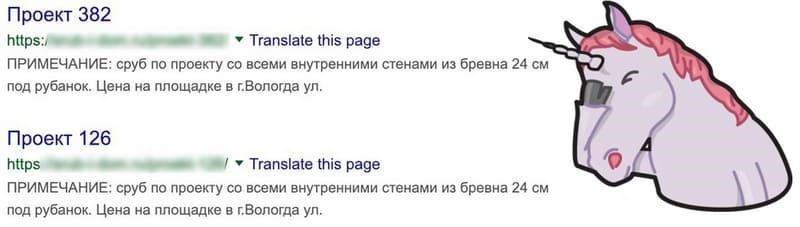

Под этим термином понимается соответствие разных страниц одному ключу. При такой ошибке поисковики не определяют, какой именно результат будет наиболее релевантным запросу. Из-за каннибализации «Яндекс» и Google индексируют только одну страницу, и эта версия часто оказывается не самой удачной.

Для сайтов с каннибализацией типична ситуация, когда поисковики по основным запросам видят второстепенные страницы, а главные разделы вообще не индексируются и не получают трафика. Это приводит к большому количеству отказов, сокращению сеансов и снижению глубины просмотров. Результатом становится нулевая конверсия с целевой страницы и общая пессимизация сайта на фоне просадки поведенческих факторов.

Причины каннибализации

К каннибализации приводят ошибки в работе с семантикой:

-

Добавление разделов и наполнение сайта контентом без составления семантического ядра. Это означает, что SEO-специалист действует интуитивно и не придерживается четкого плана.

-

Неэффективное распределение ключей по посадочным страницам. Обычно к этому приводит бессистемный сбор семантики или неправильная кластеризация. Например, оптимизатор создает две страницы под отдельные запросы — «SEO продвижение» и «SEO раскрутка». Поисковики будут оценивать два формально разных ключа как идентичные. В результате одна из страниц не попадет в выдачу. Грамотная кластеризация может предотвратить такую ошибку.

Также нужно сказать о естественной каннибализации, которая возникает из-за того, что на сайте становится больше содержимого. Даже при грамотной контент-политике на крупных веб-ресурсах из-за постоянной публикации новых материалов появляются страницы с конкурирующими ключами, что вызывает сложности с их ранжированием.

Поскольку каннибализация возникает не только из-за ошибок оптимизаторов, рекомендуется периодически проверять сайт на наличие страниц с ключами-конкурентами.

Проблемы в технической оптимизации сайта

После составления семантического ядра начинается работа по технической оптимизации ресурса. Здесь есть несколько «подводных камней», которые тормозят продвижение: медленная загрузка, проблемы с индексацией, неправильные редиректы, неоптимизированные изображения, ошибки в верстке под мобильные устройства.

Медленная загрузка

Когда сайт слишком тяжелый или медленно грузится по другим причинам, посетители раздражаются. Многие не станут ждать, пока контент загрузится и уйдут со страницы. Процент отказов увеличивается, а позиции сайта падают, потому что поисковики не любят медленные сайты. Проблемы с загрузкой нужно постоянно отслеживать и сразу же решать. Это сложный процесс, придется разбираться в тонкостях или поручить задачу техническим специалистам.

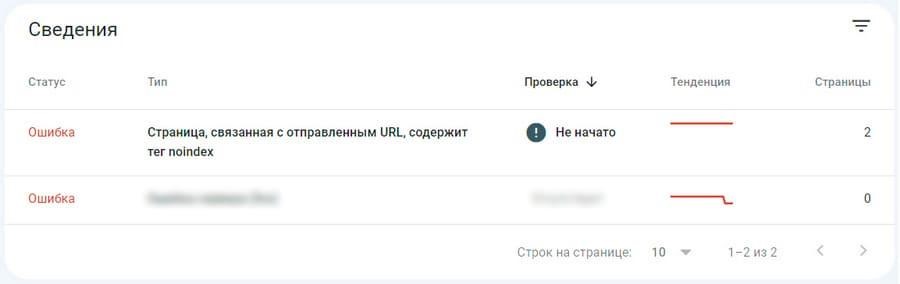

Неправильные настройки индексирования

При необходимости индексирование той или иной страницы можно запретить. В таком случае поисковые роботы не будут ее сканировать и ранжировать. Как правило, вебмастера закрывают технические страницы, чтобы не делать их общедоступными. Иногда из-за ошибочных действий оптимизаторов под запрет попадают важные разделы. В таких случаях закрытые от индексирования страницы не приносят трафик. В результате все мероприятия по продвижению оказываются бесполезными.

Как запретить поисковым системам индексировать документы:

- Добавить директиву noindex в метатеге robots в HTML-коде.

-

Прописать директивы для запрета в robots.txt.

При необходимости страницу или раздел можно закрыть от индексирования частично, а не целиком. Оптимизаторы принимают такое решение в ряде ситуаций, например, когда им нужно, чтобы поисковики не учитывали документ, но индексировали ссылки, которые он содержит.

Со временем на сайте становится все больше настроек индексирования, и этот процесс следует контролировать. При разных сценариях возможны проблемы. Прописанные директивы могут слететь при изменениях структуры сайта, переходе на другую CMS и т.д. Также нельзя исключать человеческие ошибки. Например, оптимизатор может закрыть важный документ или забыть восстановить ограниченный на время технических работ доступ. Отдельная тема — настройки индексирования через robots.txt. Во многих случаях из-за неправильно прописанной директивы закрывается доступ не к страницам, а к целым разделам.

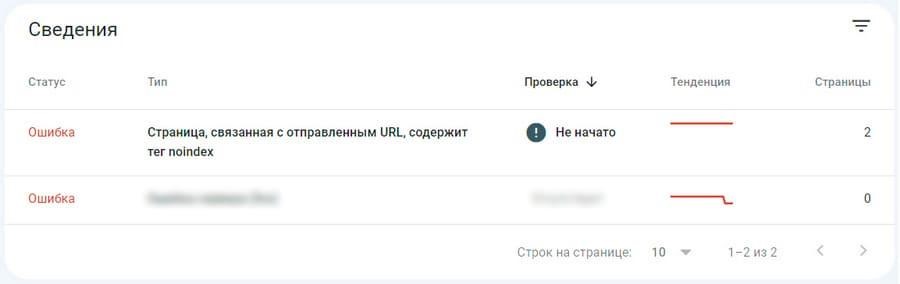

Ошибки в настройках индексирования неизбежно приводят к потере трафика. Чтобы избежать этого, можно привязать сайт к «Яндекс.Вебмастеру» и/или Google Search Console и контролировать ситуацию с помощью уведомлений. Кроме того, следует периодически проверять настройки вручную. Еще один вариант — мониторинг статуса индексирования с помощью сторонних SEO-краулеров, например, Screaming Frog и т.д.

Редирект 302 вместо 301

Чтобы передать новому URL ссылочный вес, нужно использовать 301 редирект. Он указывает, что страница «переехала» навсегда. Однако, очень часто новички в SEO используют вместо 301 редиректа 302. В то же время поисковые роботы воспринимают 302 редирект как указание именно на временное перемещение страницы. Поэтому поисковики продолжают индексировать новый URL. Вроде бы трафик перенаправлен. Но на оптимизацию ресурса он не работает.

Такое часто происходит, если редиректы настраиваются вручную в файле «.htaccess». Чтобы упростить задачу, разработчик составляет список адресов, трафик с которых нужно перенаправить, в таблице типа Excel. Это удобно, но у таких программ есть особенность.

Если в одной ячейке указать «редирект 301», а потом «растянуть» запись вниз, в другие ячейки, она не копируется. Программа воспринимает цифровую часть как номер, поэтому воспроизводит в следующих ячейках «редирект 302… 303… 304» и т.д. Невнимательность разработчика приводит к ошибкам в индексации сайта.

Изображения тоже нужно оптимизировать

Работа с картинками улучшает видимость сайта в поиске и позволяет увеличить трафик. Image SEO не требует больших усилий, однако многие напрасно не обращают на него внимания. В случае с обычными веб-ресурсами оптимизировать картинки не обязательно. При продвижении интернет-магазинов работа с изображениями становится необходимым компонентом внутристраничного SEO.

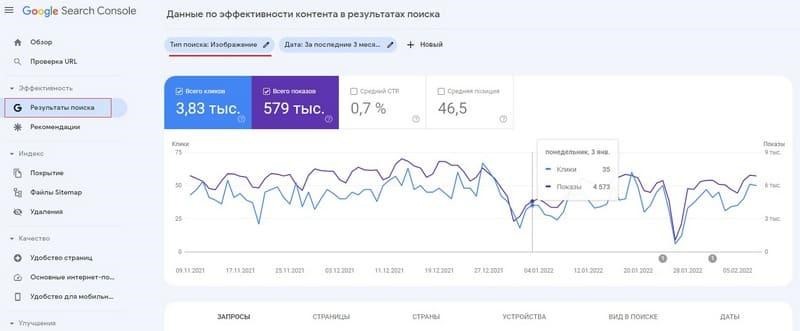

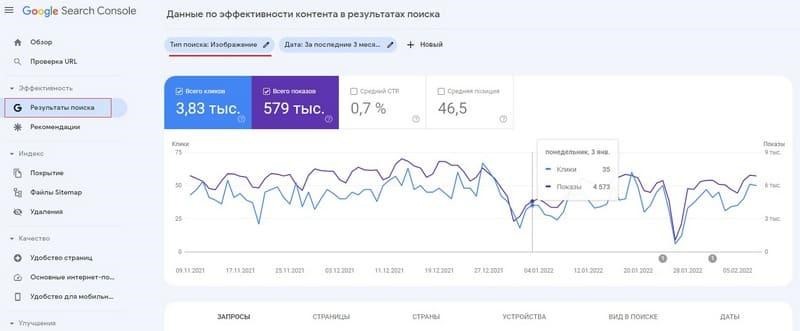

Информация об общей доле картиночного трафика содержится в Google Search Console. Там же можно увидеть другие данные о переходах по изображениям.

Эффективность — Результаты поиска — Тип поиска: Изображение

Рассмотрим наиболее распространенные ошибки Image SEO.

Непрописанные атрибуты Alt

Для успешной оптимизации изображений необходимы заполненные альты с релевантными ключами.

Правильное альтернативное описание отражает содержание картинки, включает релевантный ВЧ-запрос и не превышает лимит в 100–120 символов.

При работе с изображениями можно не прописывать тайтлы, но не стоит оставлять пустыми альты. Отметим, что в «Яндексе» Alt имеет значение только для поиска по картинкам. В Google альты дополнительно влияют на позиции в выдаче.

Другие ошибки оптимизации изображений:

- запрет на индексацию картинок в robots.txt;

- использование некачественных изображений;

- некорректное отображение фото в мобильной версии сайта;

- нелогичная структура URL для картинок;

-

размещение мультимедийных данных на сторонних хостингах;

-

использование нерелевантных изображений.

Относительно последнего пункта нужно отметить, что поисковые системы распознают то, что изображено на картинке, и сопоставляют это с другим контентом. По этой причине у фотографий должно быть релевантное текстовое окружение.

Проблемы с адаптивной версткой

Сегодня люди предпочитают делать покупки с планшетов и мобильных устройств. Отсутствие адаптивной верстки под смартфоны и планшеты или ошибки, допущенные при верстке, ухудшают продвижение ресурса. Если на десктопном устройстве сайт отображается корректно, на экране смартфона он будет выглядеть уже не так привлекательно. Следовательно, трафик с мобильных устройств будет потерян.

Для случаев, если у сайта нет мобильной версии, или если она плохо оптимизирована, долго загружается, поисковые системы предусмотрели свои технологии, которые позволяют создавать легкие и быстрые странички для мобильных устройств. Это AMP (Accelerated Mobile Pages) от Google и Турбо-страницы от Яндекс.

Дубли страниц

Дубли — страницы с уникальными URL и содержимым, которое частично или полностью совпадает. Повторение контента относится к серьезным ошибкам внутренней оптимизации. И полные, и частичные дубли значительно осложняют работу поисковых систем. Ошибкой считается повторение не только текстового содержимого, но и видео, изображений и метатегов.

Как найти дубли

Способы обнаружения дублей:

-

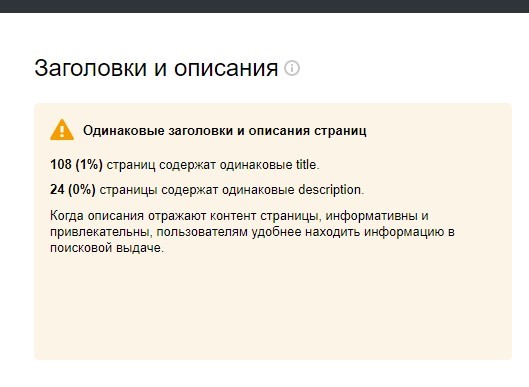

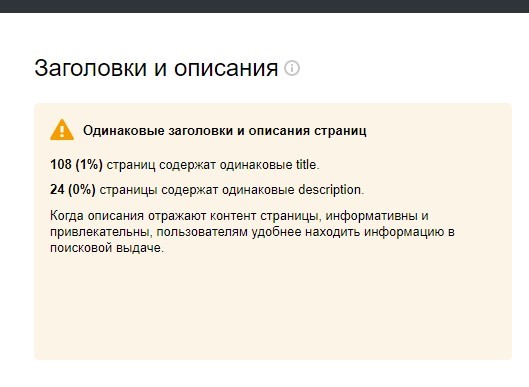

Автоуведомления от «Яндекс.Вебмастер». Информация о дублях находится в разделе «Диагностика». Не нужно подписываться на уведомления — оповещения появляются сами, иногда с небольшой — 2–3 дня — задержкой. Вы можете перейти в раздел «Заголовки и описания», там также будут отображаться все дубли метатегов.

-

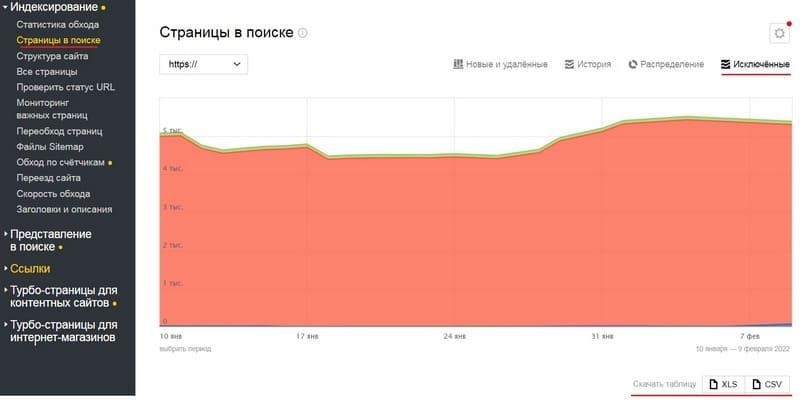

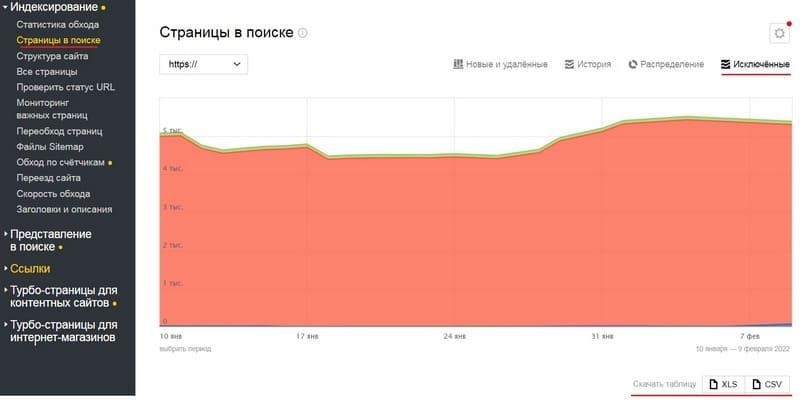

Ручная проверка с помощью «Яндекс.Вебмастер». Нужно зайти в «Индексирование», открыть «Страницы в поиске», нажать «Исключенные», выбрать подходящий формат архива и скачать его. В загруженном файле URL дубликатов будут отмечены статусом DUPLICATE.

-

Сканирование SEO-краулерами. Найти дубль можно с помощью специальных программ. К ним относится Screaming Frog, Netpeak Spider и др. Для глубокой проверки лучше использовать сторонние сервисы, а не данные из «Вебмастера».

Распространенные ошибки оптимизации тайтлов

Самая распространенная ошибка — неоптимизированные тайтлы.

Она характерна для сайтов, на которых вообще не проводились работы по оптимизации. Нельзя забывать о том, как тайтл влияет на кликабельность, поскольку этот элемент подтягивается в заголовок сниппета. Именно его пользователь видит в выдаче.

В первую очередь проблемы возникают из-за незаполненных тайтлов. Поисковые системы решают этот вопрос самостоятельно с помощью автоматической генерации заголовка сниппета, гарантировать качество и информативность которого не может никто. Кроме того, такие тайтлы не будут оптимизированы под ключи.

Иногда тайтлы слетают по техническим причинам. Например, это происходит при попытке вставить эмодзи в заголовок. Часто CMS не могут правильно обрабатывать спецсимволы, поэтому тайтлы слетают. В результате заголовок страницы остается незаполненным, и проблему никто не замечает. То же самое происходит на сайтах с большим количеством страниц, поскольку на таких ресурсах часто используются шаблоны автогенерации тайтлов. Они могут быть неправильно настроены или работать со сбоями.

Другие распространенные ошибки:

- Слишком короткие или длинные описания. Рекомендуемое количество символов в Title — 51–60.

-

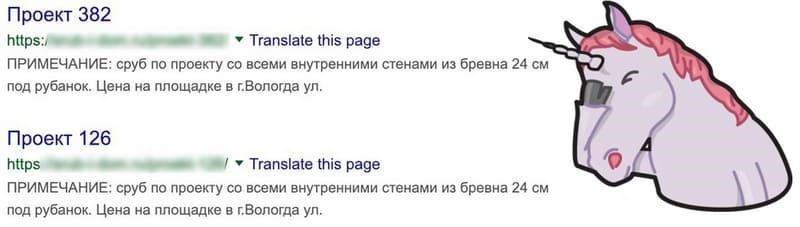

Повторение тайтлов на разных страницах.

-

Парсинг тайтлов у конкурентов, из-за которого заголовки становятся неуникальными.

-

Нерелевантность тайтла контенту.

Кроме того, важно правильно работать с семантикой. Во-первых, следует избегать переспама — одного ВЧ-запроса достаточно. Во-вторых, нужно убирать ключи типа «лучший», «дешевый» и т.п. Наконец, надо настроить ГЕО, если это актуально.

Отметим, что в 2021 году Google кардинально изменил принципы обработки тайтлов и стал гораздо чаще самостоятельно генерировать заголовки. Тем не менее не стоит пренебрегать оптимизацией тайтлов в соответствии с общепринятыми стандартами. Кроме того, рекомендуется регулярно проводить их аудит.

Непроработанные заголовки H1

Как правило, неоптимизированным тайтлам сопутствуют непроработанные H1. Рассмотрим типичные ошибки, которые связаны с внутристраничными заголовками.

Отсутствие H1

С одной стороны, «Яндекс» и Google могут индексировать и отображать в выдаче страницы без H1. С другой стороны, в таком случае поисковые системы не получают важные SEO-сигналы. При прочих равных страницы с оптимизированными H1 лучше индексируются и попадают на более высокие позиции.

Несоответствие H1 тайтлу

Заголовки должны быть разными, но не противоречить друг другу по смыслу, иначе поисковые системы не смогут точно определять, с каким из запросов соотносится страница. Такая рекомендация стала для SEO-специалистов общепринятой. В тайтле следует прописывать главный ВЧ-запрос, а в H1 — второй по важности ключ из кластера для оптимизации страницы.

Для обоих заголовков разрешается использовать один и тот же ключ, желательно — в разных словоформах. Кроме того, при оптимизации H1 стоит избегать переспама — достаточно 1–2 вхождений.

Избыток H1 на одной странице

H1 отличается от других заголовков тем, что он используется на странице один раз. Многократное повторение тега снижает ценность его сигналов для поисковых алгоритмов. В худшем случае «Яндекс» и Google могут посчитать страницу заспамленной и неинформативной. Рекомендуется помещать заголовок как можно ближе к началу HTML-документа и не дублировать на других страницах.

Нарушенная последовательность вложенности H1, H2 и H3

Соблюдение логической иерархии — обязательное условие работы с заголовками разного уровня. Их неправильное расположение не относится к серьезным ошибкам, но влияет на то, как алгоритмы разбираются в структуре документа и оценивают релевантность страницы.

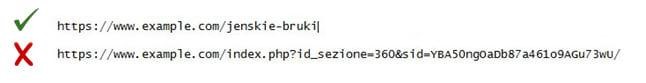

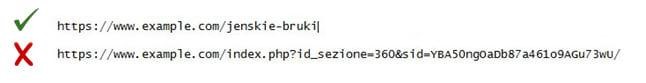

Ненастроенные ЧПУ — человекопонятные УРЛы

Рекомендуем всегда приводить структуру URL к человекочитаемому формату. В противном случае краулерам будет сложно обходить страницы, а это вызовет проблемы с индексацией. Подробнее о ЧПУ мы рассказали здесь.

Хороший URL — это короткий и понятный идентификатор, а не рандомный набор символов.

Человекопонятные УРЛы служат вспомогательными инструментами навигации, благодаря которым пользователи определяют уровень вложенности (по аналогии с «хлебными крошками»).

Кроме того, сниппеты с человекопонятными УРЛами выглядят информативнее и привлекательнее, а это положительно влияет на кликабельность.

Таким образом, настройка ЧПУ как прямо (через индексирование), так и косвенно (через поведенческие факторы) определяет качество поисковой оптимизации.

Неоптимизированные внутренние ссылки

Сигналы с других сайтов играют важную роль в продвижении, поэтому SEO-специалисты внимательно относятся к обратным ссылкам. Кроме того, необходимо оптимизировать внутренний ссылочный профиль.

Рассмотрим типичные ошибки, которые возникают при работе с внутренними ссылками.

Отсутствие перелинковки

Связывать друг с другом страницы сайта помогают внутренние ссылки. Они образуют систему перелинковки, которая также относится к важным компонентам оптимизации. Специалисты рекомендуют на каждую более или менее авторитетную страницу ставить ссылку из другого раздела.

Если на документ не ссылаются другие страницы, то он хуже индексируется, поскольку роботы не всегда могут его обнаружить. Кроме того, отсутствие перелинковки замедляет продвижение. Если странице не передается PageRank, то это снижает ее поисковый авторитет.

Основное правило перелинковки: авторитетные страницы необходимо связывать с менее трастовыми.

Кроме того, нужно поддерживать актуальность перелинковки. Чтобы обнаружить разделы, на которые не ссылаются трастовые страницы, можно использовать SEO-краулеры.

Переизбыток ссылок на одной странице

Количество линков на странице зависит от ряда факторов, в том числе от особенностей верстки. Также имеет значение специфика содержимого. Например, в листингах по умолчанию больше ссылок, чем в других разделах.

Из-за переизбытка ссылок нерационально расходуется краулинговый бюджет, что приводит к проблемам с индексированием. Отметим, что такие сценарии актуальны для крупных веб-ресурсов. При количестве URL менее 100 000 о краулинговом бюджете можно не волноваться.

Отсутствие атрибутов в исходящих ссылках

Ссылаться на сторонние ресурсы — это нормально. Главное — учитывать возможные риски. Во-первых, следует ссылаться только на качественные веб-ресурсы и страницы с тематически релевантным содержимым. Кроме того, необходимо использовать атрибут nofollow. Им нужно помечать ссылки на любые сайты. Этот атрибут предотвращает перераспределение ссылочного веса и помогает избежать негативных последствий при работе с некачественными ресурсами.

Ссылки, которые размещаются на коммерческой основе или относятся к партнерским программам, нужно отмечать атрибутом sponsored (лучше в связке с nofollow).

Для ссылок, которые посетители оставляют в комментариях, необходимо использовать связку атрибутов nofollow и ugc. Такие линки нужно тщательно модерировать.

Большое количество битых ссылок

Неработающие ссылки, которые приводят на страницы с ошибкой 404, вызывают недовольство и у пользователей, и у поисковиков. Отметим, что появление битых ссылок — это нормально, особенно при постоянном активном обновлении ресурса. Важно контролировать их количество. Если масса неработающих ссылок превышает критическую отметку, то поисковый рейтинг сайта снижается. Также из-за переизбытка битых ссылок нерационально расходуется краулинговый бюджет.

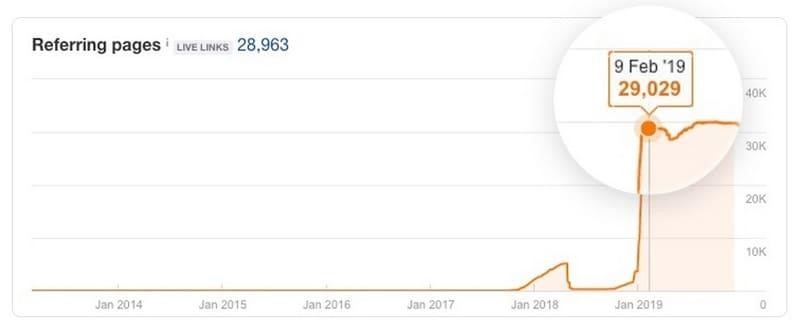

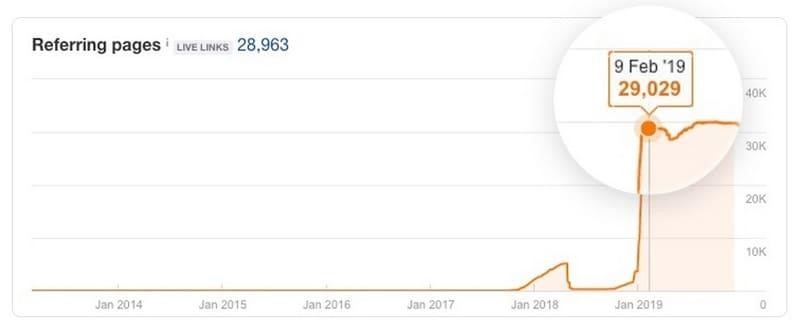

Проблемы с обратными ссылками

Ссылки со сторонних ресурсов могут быстро повысить поисковый авторитет сайта. Важно разбираться во всех нюансах линкбилдинга, чтобы избежать фатальных ошибок. При анализе ссылочного профиля необходимо обращать внимание на следующие факты:

-

Аномально резкое увеличение количества обратных ссылок. Это может говорить о ссылочном взрыве — приеме черного SEO, за счет которого конкуренты хотят подвести сайт под фильтры.

-

Наличие подозрительных доноров. К ним относятся сайты серых тематик, ссылочные каталоги низкого качества, взломанные сайты, ресурсы, которые были подняты с помощью спарсенного или сгенерированного контента.

-

Множество ссылок с тематически нерелевантных ресурсов или подозрительных доменных зон.

-

Увеличение количества обратных ссылок с вхождением ключей. Такие бэклинки относятся к инструментам черного SEO и представляют опасность, поскольку из-за них можно попасть под фильтр.

Отсутствие технических страниц

Часто владельцы сайтов не добавляют технические страницы — пользовательское соглашение, политику конфиденциальности и др. Многие считают, что этой формальностью можно пренебречь. Тем не менее поисковые системы больше доверяют веб-ресурсам с техническими страницами.

При использовании шаблонного пользовательского соглашения или политики конфиденциальности страницы с неуникальным текстом можно закрыть от индексирования. Вероятнее всего, это не повлияет на результат.

Неудачные форматы контента

И посетители сайта, и поисковики любят, чтобы контент на странице был разнообразным. Никого не интересует пара-тройка тысяч слов сплошного текста.

Нужны элементы, которые его разбавят:

- картинки и схемы;

- таблицы и списки;

- инфографика и видеообзоры.

Мышление современного пользователя характеризуют как клиповое. Чтобы задержать его внимание, нужен неоднородный контент. Статья должна быть действительно информативной и уникальной. Яркие картинки, короткие и актуальные видеоматериалы, схемы и списки хорошо удерживают внимание.

Если посетитель воспринимает материал как интересный, он делится ссылками, постит в соцсетях и т.п. Все это дает сайту дополнительный трафик, улучшает поведенческие характеристики, дает новые внешние ссылки. Растет трафик, сайт движется вверх в поиске.

Резюме

Мы рассмотрели наиболее частые ошибки в SEO при самостоятельном продвижении сайта. Надеемся, что материал был для вас полезным и вы используете его в качестве руководства к действию.

А если вы уже долгое время безуспешно пытаетесь продвинуть свой сайт в поисковиках, воспользуйтесь нашей услугой SEO-аудита или закажите консультацию менеджера компании INTEC. Мы вместе выявим и разберем ошибки продвижения, а также найдем варианты их решения.