Дублями называются веб-страницы, содержимое которых частично либо полностью совпадает. Дублирование приводит к тому, что сайт начинает терять трафик. Сегодня расскажем о том, как с этим бороться.

Как и почему дубли веб-страниц затрудняют SEO

Из-за дублирования поисковые системы не могут определить, какую именно из страниц, которые соответствуют релевантным запросам, необходимо показывать в выдаче. В результате поисковики снижают позиции сайта в ранжировании либо вообще банят его. По этой причине SEO-специалисты рекомендуют проверять продвигаемые ресурсы на наличие дубликатов.

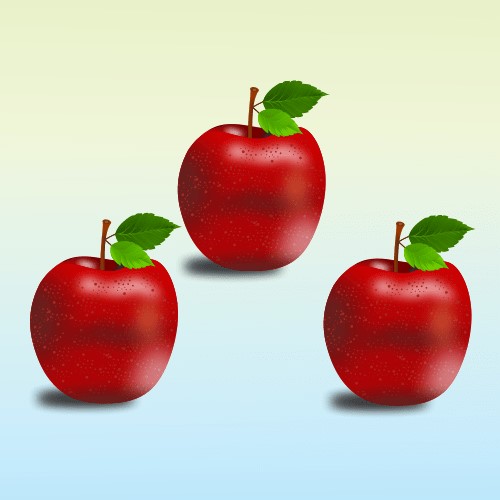

Вопрос о том, почему дубли осложняют продвижение, можно рассмотреть на простом примере. На картинке ниже изображены три яблока.

Яблоки на картинке ничем не отличаются. Все они соответствуют запросу «красное яблоко», и выбрать фрукт, который больше других подходит под это определение, очень сложно.

С такими же затруднениями сталкиваются поисковые системы, если на сайте есть несколько частично похожих или полностью идентичных страниц.

Из-за наличия страниц-дубликатов возникают следующие проблемы:

- Снижение релевантности основной продвигаемой страницы и ее позиций по ключевым словам.

-

Изменение страницы поисковыми системами для показа в выдаче, что также приводит к нестабильности позиций по ключевым словам.

-

При наличии большого количества дублей — попадание под фильтры «Яндекса» и Google.

Виды дублей

Дубли бывают полные и частичные.

Полный дубль — страница, которую поисковые системы находят по разным адресам.

Причины появления полностью идентичных страниц:

- Отсутствие главного зеркала. Это одна из наиболее распространенных причин. Если разработчики забывают указать главное зеркало, то сайт может выходить в поиске в нескольких вариантах — с www и без него, с http и c https.

-

Особенности CMS или действия разработчика. Например, главная страница может быть доступна со слешем в конце и без него, с добавлением слов start, php и т.д.

-

Попадание в индекс страниц с динамичными адресами. Как правило, это происходит, если используются фильтры для сортировки и сравнения различных товаров.

-

Самогенерация дублей некоторыми движками — WordPress, Joomla, OpenCart, MODX. Например, в Joomla часть страниц автоматически отображается с разными URL —mysite.ru/catalog/25 и mysite.ru/catalog/25-article.html и т.п.

-

Отслеживание сессий с помощью специальных идентификаторов, которые также могут индексироваться и создавать дубли.

-

Добавление к адресам страниц UTM-меток. Они используются, чтобы отслеживать, насколько эффективно проходят рекламные кампании. Теоретически страницы с UTM-метками не должны индексироваться, но на практике они часто встречаются в выдаче.

Полные дубли легко обнаружить и удалить, в отличие от частичных.

Подпишитесь на нас в Telegram

Получайте свежие статьи об интернет-маркетинге и актуальные новости о наших готовых решениях

Рассмотрим причины, по которым появляются частичные дубли.

Пагинация страниц

С помощью пагинации можно упростить навигацию по сайту и одновременно осложнить продвижение.

Каждая страница пагинации представляет собой дубликат, часто — с такими же метаданными и SEO-текстом.

Например, адрес главной страницы — https://mysite.ru/women/clothes. При этом страница пагинации выглядит так: https://mysite.ru/women/clothes/?page=2. В результате появляются две страницы с разными адресами и практически одинаковым содержимым.

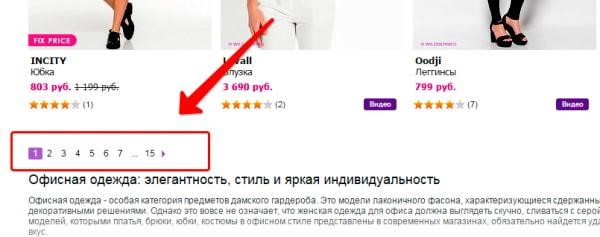

Блоки новостей, топовых статей и комментариев

Чтобы посетители как можно дольше оставался на сайте, ему предлагаются последние новости, популярные статьи и интересные комментарии. Их заголовки с частью содержимого обычно размещаются справа, слева или снизу от основного материала. Эти фрагменты не должны индексироваться, иначе поисковик обнаружит разные страницы с одинаковым контентом.

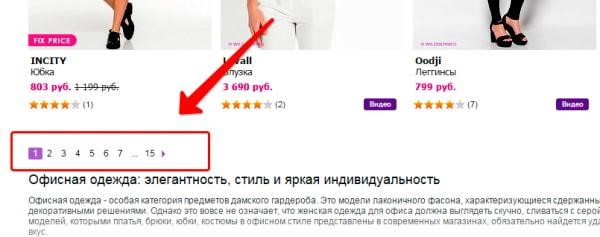

Как видно на картинке, внизу главной страницы находится три блока с новостями, последними статьями и новыми отзывами. Их текстовое содержимое можно найти в соответствующих разделах. При этом контент повторяется на главной странице, из-за чего создаются частичные дубли.

Наличие версий страниц для печати

Часть страниц сайта доступна в двух вариантах — обычном и для печати. Вторая версия отличается от основной адресом. Кроме того, в ее коде отсутствуют многие строки, поскольку странице для печати не требуется значительная часть функционала.

Чтобы понять разницу, можно сравнить адреса обычной страницы и версии для печати: https://my-site.ru/page и https://my-site.ru/page?print.

Применение технологии AJAX

Иногда на сайтах, при создании которых использовалась технология AJAX, появляются HTML-слепки. Они не представляют опасности для продвижения, если AJAX-страницы индексируются правильно. В противном случае поисковые боты выходят не на основную страницу, а на слепок. В результате одна страница индексируется по двум адресам — главному и HTML-слепка.

Чтобы найти слепок, нужно в основном адресе заменить «!#» на код «?_escaped_fragment_=».

Опасность частичных дублей заключается в том, что они не приводят к одномоментной значительной потере позиций, а незаметно ухудшают продвижение сайта.

Как искать дубликаты веб-страниц

Выявлять дубли можно вручную или с помощью специализированных программ или онлайн-сервисов.

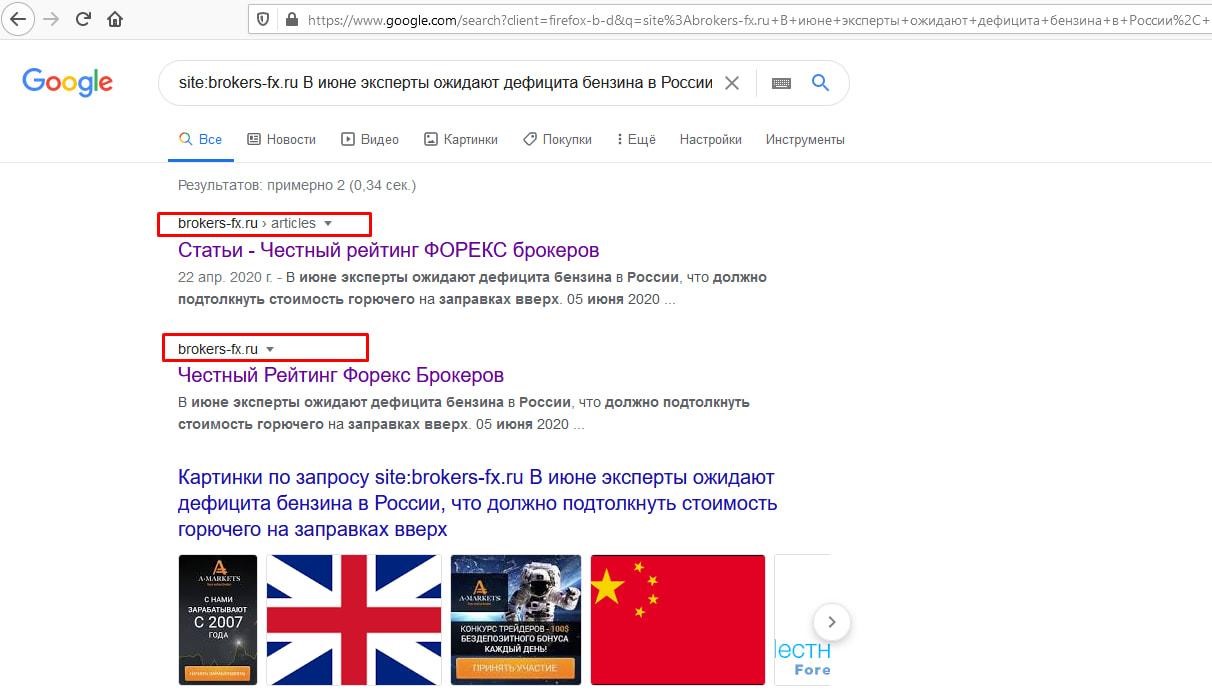

Ручной способ

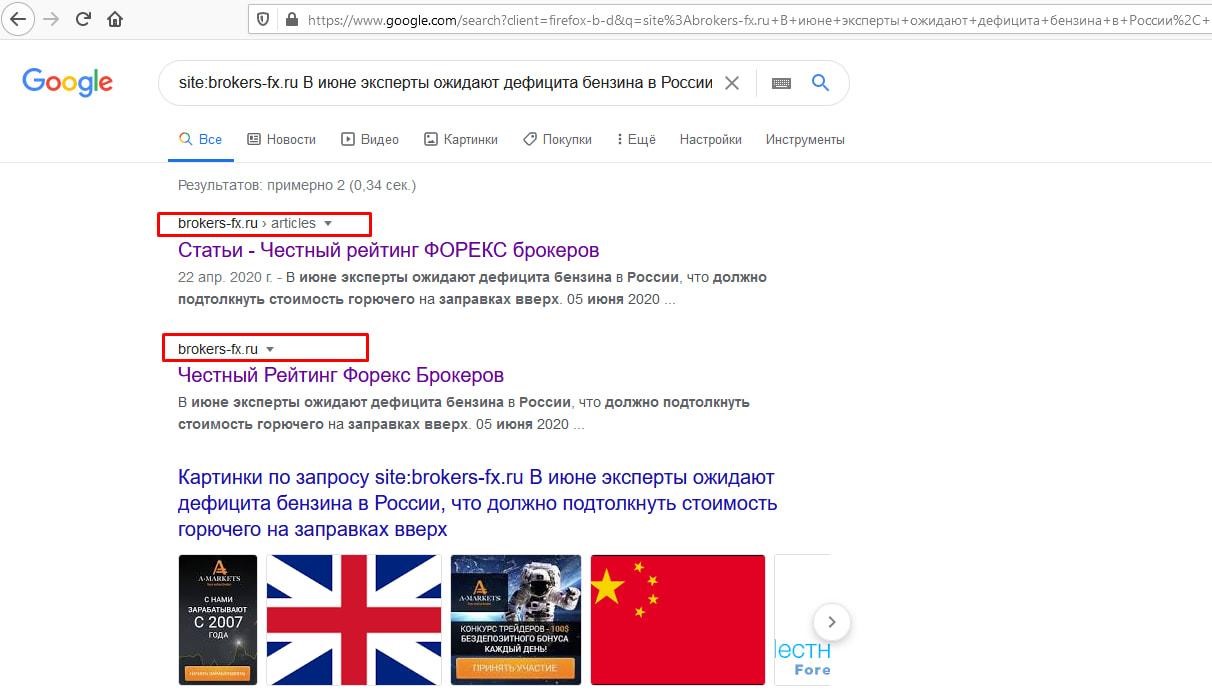

Найти дубликаты можно с помощью команды site. Ее нужно вставить в адресную строку и после нее ввести домен и часть текстового содержимого, чтобы Google выдал все существующие варианты.

Как видно на картинке, после команды site в адресную строку было введено первое предложение статьи. Поисковая система обнаружила, что основная страница с текстовым содержимым частично дублируется на главной.

Применение специализированных программ

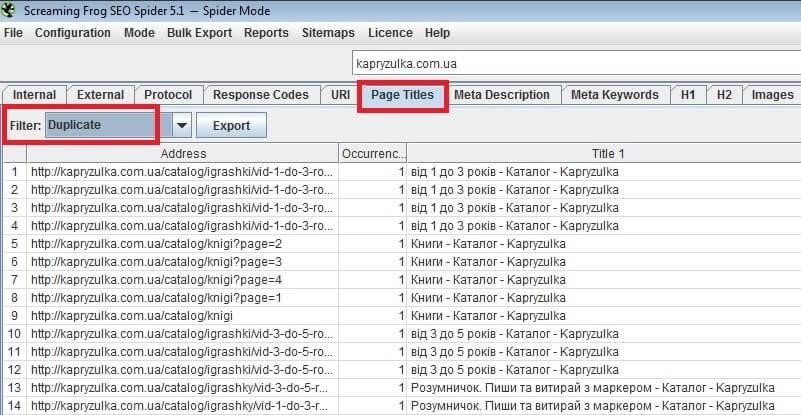

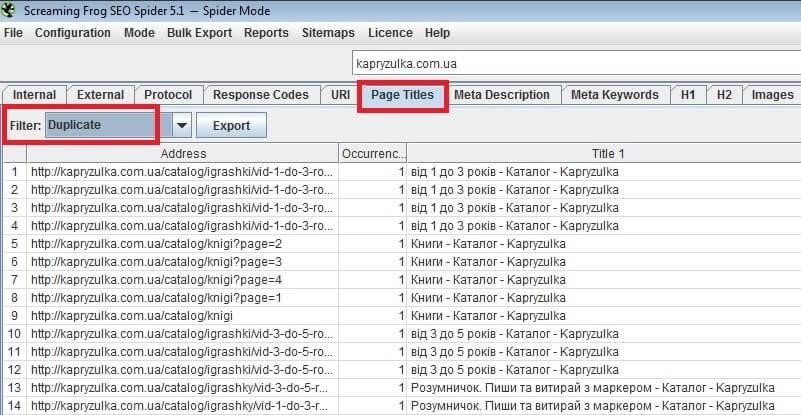

Искать дубликаты можно с помощью различных программ, например, Xenu. Это бесплатный сервис. Еще одна программа — Screaming Frog. Ее стоимость составляет 149 фунтов в год. Также разработчики предлагают ограниченную бесплатную версию, функционала которой достаточно для решения большинства задач.

Применение Google Search Console и «Яндекс.Вебмастер»

Чтобы найти дубли с помощью Google Search Console, нужно проверить «Предупреждения» и «Покрытие». Там содержится информация о страницах, которые Google считает проблемными.

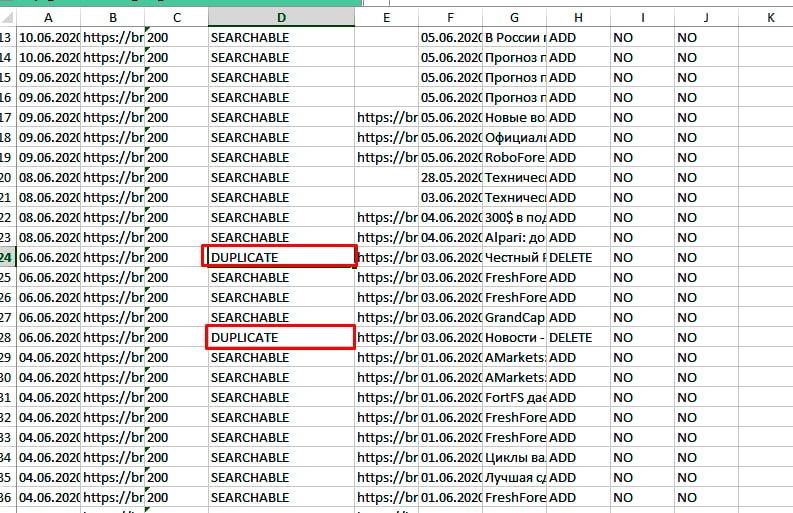

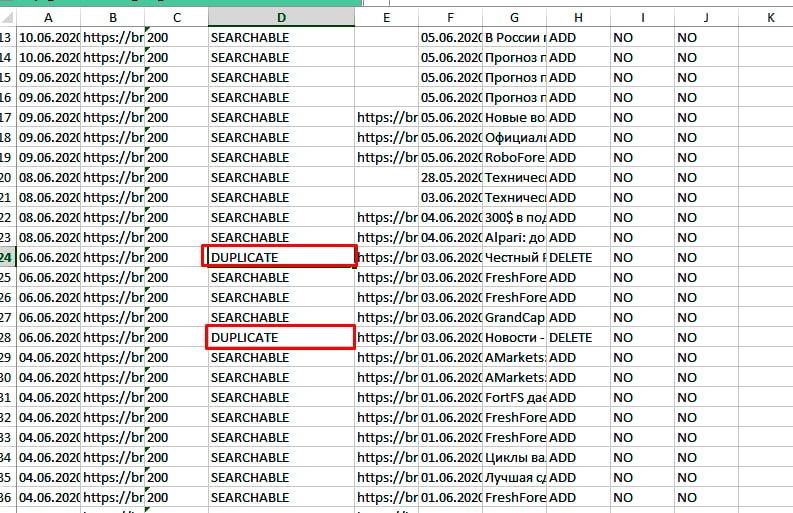

В «Яндекс.Вебмастере» данные о дублях находятся в разделе «Индексирование», где нужно зайти в «Страницы в поиске» и спуститься вниз. Далее следует выбрать справа формат файла — CSV либо XLS, скачать его и открыть документ. Все дубли в строке «Статус» должны быть помечены как DUPLICATE.

Как удалить дубли страниц

Рассмотрим способы удаления дубликатов.

С помощью noindex и nofollow

Проще всего закрыть страницу от индексации. Для этого метатег <meta name=”robots” content=”noindex,nofollow”/> нужно поставить в шапку между открывающим тегом <head> и закрывающим </head>. После этого поисковые системы перестанут индексировать страницу и учитывать те ссылки, которые на ней находятся.

Важно: при использовании метатега нельзя запрещать индексацию через robots.txt.

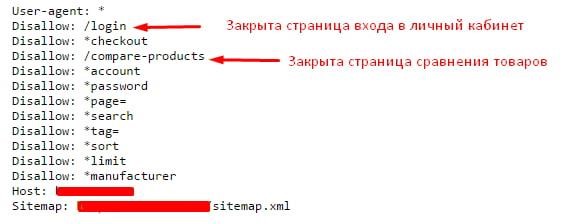

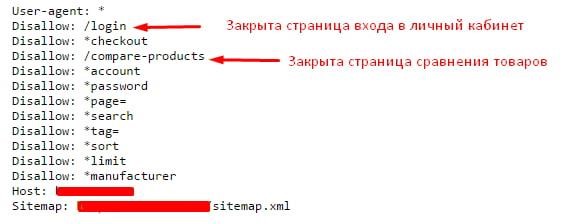

С помощью robots.txt

Индексацию дубликатов можно запретить в robots.txt через директиву Disallow. Для этого в файл нужно добавить такой код:

User-agent: *

Disallow: /dublictate.html

Host: mysite.ru

Запрет индексации через robots.txt часто используется для служебных страниц.

Такой способ становится альтернативным решением, если запрет через Disallow не работает.

С помощью canonical

Этот метатег сообщает поисковым роботам, что перед ними находится дубликат, а также указывает им на основную страницу. Сanonical нужно поместить между тегами <head> и </head>: <link rel=”canonical” href=”адрес основной страницы” />.

Как удалить дубли со страниц с пагинацией

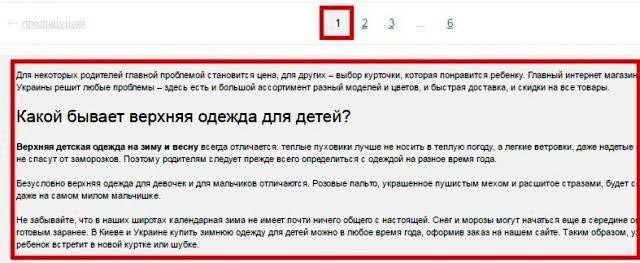

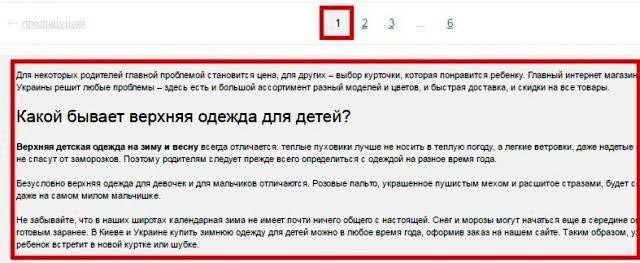

Для сайтов с многостраничными каталогами типична ситуация, когда на второй и следующих за ней страницах появляются дубли.

Так выглядит первая страница каталога.

На второй и следующих за ней страницах дублируется текст и теги <title> и <description>.

SEO-специалист должен сделать так, чтобы текст отображался только на первой странице. Кроме того, нужно убрать дубли <title> и <description>. У каждой страницы должны быть уникальные теги. Также необходимо убедиться, что в адресах страниц пагинации отсутствуют динамические параметры.

Понимание того, что такое дубли страниц и как их устранить, поможет избежать попадания в индекс копий, которые осложняют продвижение сайта.